CRO特化のWebマガジン『CRO/Tips』です。本記事ではA/Bテストの基礎知識について徹底的に解説します。A/Bテストの実施を検討している方、サイト改善のノウハウを探している方向けに、A/Bテストとはどのような手法なのか、具体的なテストのやり方やA/Bテストの落とし穴、そしておすすめのA/Bテスティングツールについてもご紹介します。A/Bテストについての基本的な知識や概要理解の助けになると幸いです。

A/Bテストとは?

A/Bテストとは、複数のバージョンをランダムに比較検証して統計的にパフォーマンスが高い方を採用する改善プロセスです。マーケティングにおけるCRO(Conversion Rate Optimization )やグロースハックの文脈で主に使われます。サービス改善においてほぼ必須ともいえる手法です。

A/Bテストのメリット

A/Bテストには様々なメリットがあります。代表的なものをいくつか挙げていきます。

変更の影響を高い確率で予測できる

A/Bテストのメリットは、少ない人数にテストすることで実際のユーザーや訪問者にどのような影響がでるかを予測できます。例えば、100万人規模のサイトで変更を行う場合、その結果は実際のユーザーに見てもらう、つまりフタを開けるまでわかりません。1,000人にA/Bテストを行うことで100万人への影響を高い確率で予測できます。

低コストで実行できる

一般的に実装には多くの工数がかかります。加えて、テストをする場合はユーザーの出し分けなど高度な実装も必要になるため、テストのために開発を行うことは現実的ではありません。現代のA/Bテストは、テストツールの利用が主流です。多くのA/Bテストツールはローコード(ノーコード)で利用でき、ドラッグ&ドロップでサイトの表示変更を行えるものも多いです。そして、このようなテストツールは無料で使えるサービスも多いため、低コスト・少ない工数で実行ができます。

元の状態にすぐに戻せる

一般的に本番実装は不可逆性が高いです。つまり、簡単に後戻りができません。もしも、効果が悪い場合も元のバージョンに戻すことは非常に難しいことが多いです。A/Bテストはサイトのコード変更を行うものではないため、効果が悪いバージョンを戻すことが可能です。

A/Bテストのデメリット – 失敗ケース

A/Bテストは適切に進行すると様々メリットがある一方で、やり方を間違えるとサービスにとってデメリットになってしまうケースがあります。以下のような状況には気をつけましょう。

意味のないテストをしてしまう

テストの肝は仮説設計です。仮説設計がうまくできていない場合、テスト結果そのものがあまり意味のないものになってしまいます。必ずテストの目的や解決したい課題を吟味しましょう。

誤ったテスト結果によってサービスにネガティブな影響が出てしまう

A/Bテストの方法を間違えてしまうと改善につながりません。例えば、実際はパフォーマンスがよくないパターンを採用してしまったり、逆に本来パフォーマンスが良いパターンを不採用にしてしまうと、サービスの改善にとって不利益となってしまいます。また、不十分なQAやテスト中のユーザー体験の変化をモニタリングできていないことで既存ユーザーにネガティブな影響が出てしまう可能性もあります。

こういった負の側面は事前の準備や進行時のケアで解消できるものも多いです。本記事では適切なテストの進め方についても解説していますのでぜひご参考ください。

A/Bテストと統計は表裏一体

A/Bテストを語るうえで絶対に外せないのが統計です。統計を理解していないと、効果的なA/Bテストはできないと言っても過言ではありません。

そもそもA/Bテストは統計的な仮説検定の一手法です。考え方としては、テスト対象の2つのデータセットについて仮説を構築し、比較検証して、統計的に有意な関係があるかどうかを判断するプロセスです。例えば、「ファーストビューのビジュアルについて、パターンAはパターンBよりもパフォーマンスが良いだろう」というような仮説をたて、実際にパターンAが統計的に有意なパフォーマンスを出しているかを観察します。

A/Bテストの勝敗はどうやって決めるの? | 統計的有意性

そもそもですがA/Bテストの勝敗はどのように決めるのでしょうか?「あらかじめ決めた時間が経過した時?(2週間?3週間?)」「どちらかのパターンのCVRに圧倒的に差が出た時?(その「差」はどのように判断する?)」

一般的にA/Bテストの勝敗を決めるのは「テスト結果が偶然でないと統計的に示せる状態」になった時です。この状態を統計的有意といいます。

さて、そうなると統計的に有意になったかどうかはどのように判断するのでしょうか?以下に主なポイントを示します。

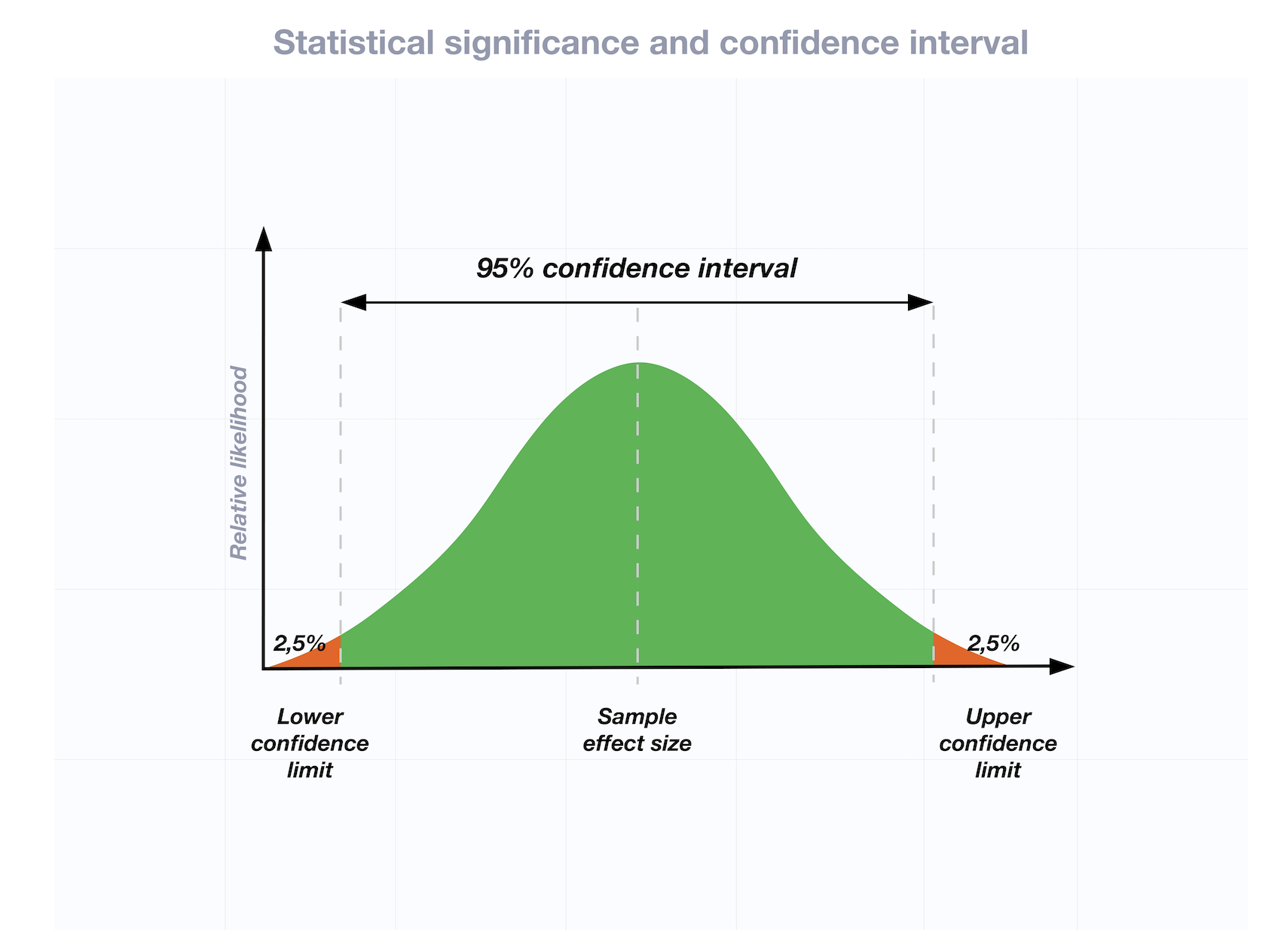

p値と有意水準

少し専門的になりますが、統計的有意性を判断するのに重要な概念が「p値」です。

帰無仮説の下で実際にデータから計算された統計量よりも極端な(仮説に反する)統計量が観測される確率を、「p値」という。(参照:wikipedia)

ざっくり言いますと、A/Bテストは「オリジナルよりもテストパターンの方がCVRが高い」という仮説を検証するために行われます。A/Bテストの勝敗の具体的な目安として、p値が5%より小さい状態になると有意差ありと判断されます。一般的にはこのp<0.05を有意水準として判断します。少し言い換えると、p値5%とは、ABテストで勝者を宣言する場合に、その宣言が正しい確率が95%であることを意味します(=コントロールとテストとの間に95%の信頼度で有意な結果の差があることを意味します)。

検出力

p値とともに重要なのが「検出力」です。テストをする場合「実際はAとBの差がないのに差があると判定された」「実際はAとBは差があるのに差がないと判定された」といったエラーが生じることがあります。これらのエラーは、サンプルサイズやp値などと密接に関わっています。検出力についても簡単に表現すると「実際に差がある時に、差があるといえる確率」と言い換えることができます。一般的に検出力は80%以上に設定します。

本記事では詳細な説明は省きますが、統計的な観点はテストの信頼性について重要な要素であるためこれらを無視してA/Bテストを行うことは基本的にはありません。

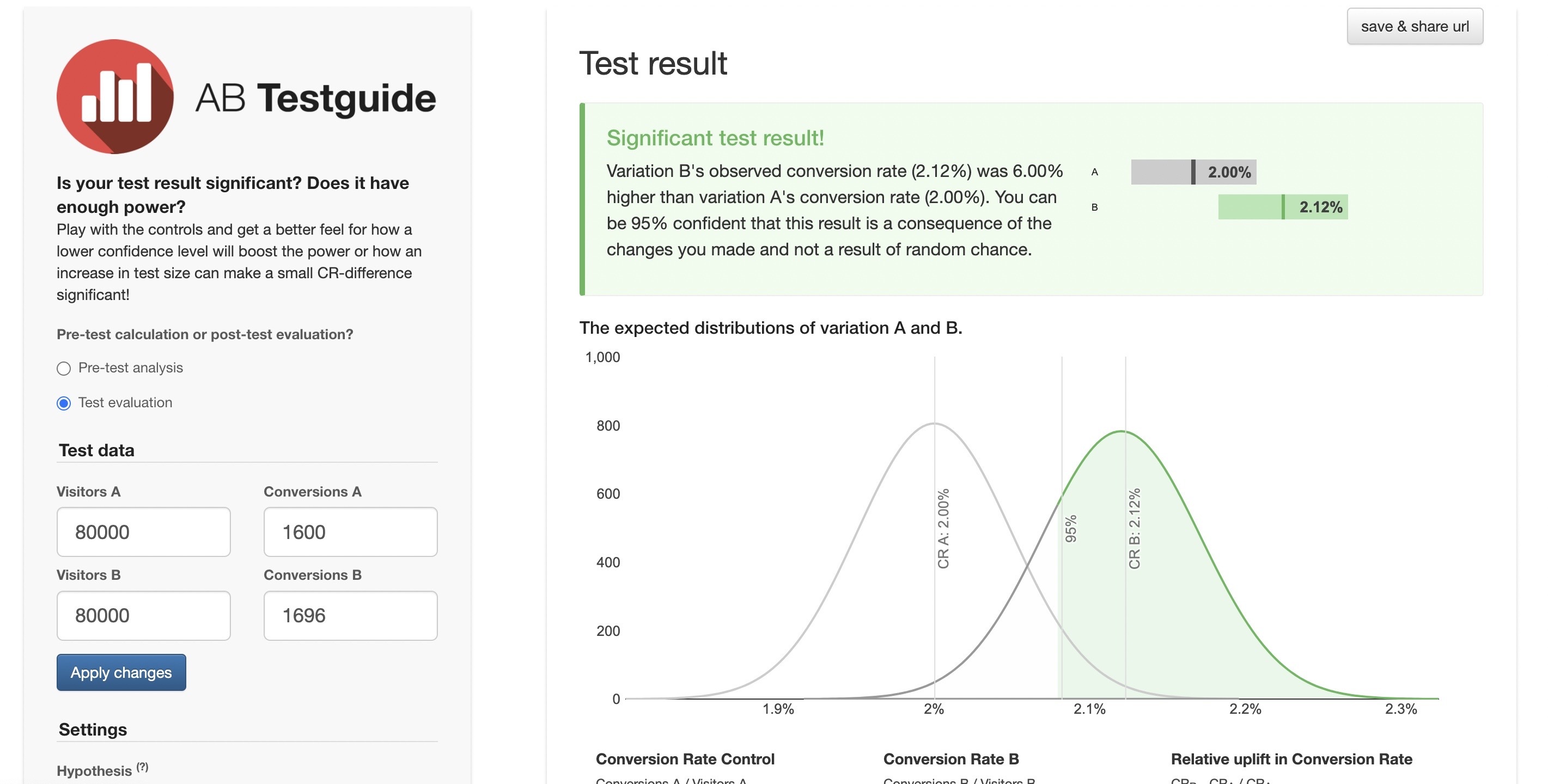

実務的な話では、A/Bテストにおけるp値や検出力の計算はA/BTestguite.comなどの計算ツールを使ってかなり手軽に試算できます。対象サイトのトラフィック数、コンバージョン数などの実績を入力することでテスト結果が有意かどうか判定できます。

A/Bテストにどのくらいの日数がかかるの? | MDE

前述でテストの勝敗は統計的に有意な状態になったかが重要な要素であるとお話しましたが、実際にA/Bテストをプランニングする際は「どの程度の日数で結果が出るのか」を見積もる必要が出てきます。「2週間で結果が出ると思ったら、そもそもトラフィック数が大幅に少なくて6ヶ月たってもいまだ結果が出ない」となってしまったら目も当てられません。

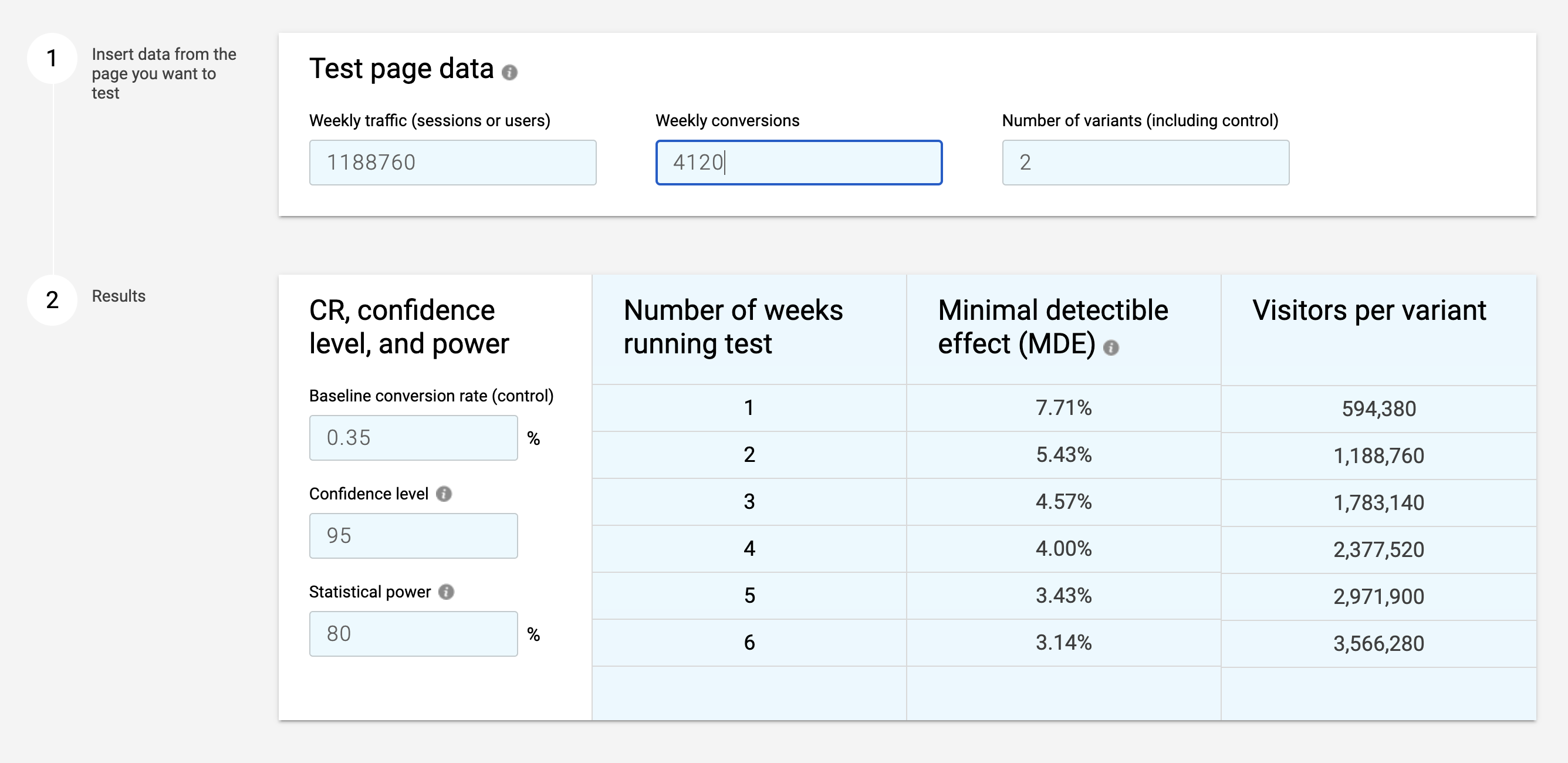

そこで、必要な概念がMDEです。MDEを調べることで「今のトラフィック数・CV数だと、どの程度の期間でどの程度のCVR差が出たら統計的に有意といえる」かと見積もることができます。

MDEとは

さて、MDEとは何でしょうか?MDEはMinimum Detectable Effectの略で、検出可能な最小の改善幅を推定する計算となります。一定の確実性をもって検出したいリフトの最小値を見積もることで、テストにどれだけのトラフィックや時間を投資するかをシミュレーションできます。

A/Bテストを行う際はこのMDEを必ずプランしましょう。AB+ Test Calculator by CXLでは現在のトラフィック数やテストパターン数などを入力して簡単にMDEを算出できます。

例えば、現状のトラフィックを考慮すると1週間で7.71%の差が出ればその時点で勝敗決定できるといったシミュレーションが可能です。

A/Bテストのやり方

前半でA/Bテストの概要について解説を行いました。後半ではA/Bテストの実際の進め方について触れていきます。

(Step1)課題抽出 / 仮説設計

「そもそもテストによってどのような課題を解決したいのか」「課題解決のためにどのような仮説が考えられるのか」これらの整理が第一歩となります。課題を見つけるために様々な調査や分析を行います。

- 調査・分析:定量調査、定性調査、ヒューリスティック調査

- 仮説設計:仮説リストの作成、優先順位づけ

分析や仮説設計については様々なフレームワークがあります。是非ご参考ください。

(Step2)テストプラン作成

前ステップで抽出した課題をもとにテストプランを作成します。前出のA/BTestguite.comなどを活用してテストが成立するか必ずシミュレーションを行いましょう。

- テストが可能な環境か:トラフィック数やコンバージョン数は十分か

- バリエーションは何パターンが良いか

A/Bテストの種類

さて、A/Bテストと一口に言ってもいくつか種類が存在します。目的や前提に応じて適切な方法を選びましょう。

スプリットテスト

一般的なA/Bテスト(スプリットテストとも言われます)は、サイトの特定のエリアについて複数のパターンを比較検証します。A/Bテストのお作法として、必ずオリジナル(既存)パターンとテストパターンを比較します。一例として、Aパターン(オリジナル)とB(テストパターン)、C(テストパターン)を比較するようなイメージです。万が一、オリジナルパターンを入れずにテストパターンだけでテストを行ってしまった場合、既存パターンとの比較ができないためテストが成立しません。そもそもテストの目的が「既存パターンより新しいパターンの方がCVRが高い」ことを確かめるためではありますので当たり前といえば当たり前なのですが。

リダイレクトテスト

前述のスプリットテストが同じページ内で行われることに対して、リダイレクトテストはページ単位でテストを行います。ページA(オリジナル)対、ページB(テスト)のように行います。

多変量テスト

スプリットテストが原則1要素の検証に対して、多変量テストは複数要素の組み合わせをテストします。変数A(ファーストビュー)と変数B(ソーシャルプルーフエリア)と変数C(事例エリア)のように独立した要素のテストを同時に掛け合わせて行います。多変量テストは様々な変数の勝敗および変数同士の効果的な組み合わせが一度にわかるというメリットがある一方で、1要素のスプリットテストと比較すると必要となるサンプル数が多くなります。このため一般的にはトラフィック数が多くコンバージョン数も多いサービスに向いている手法となります。

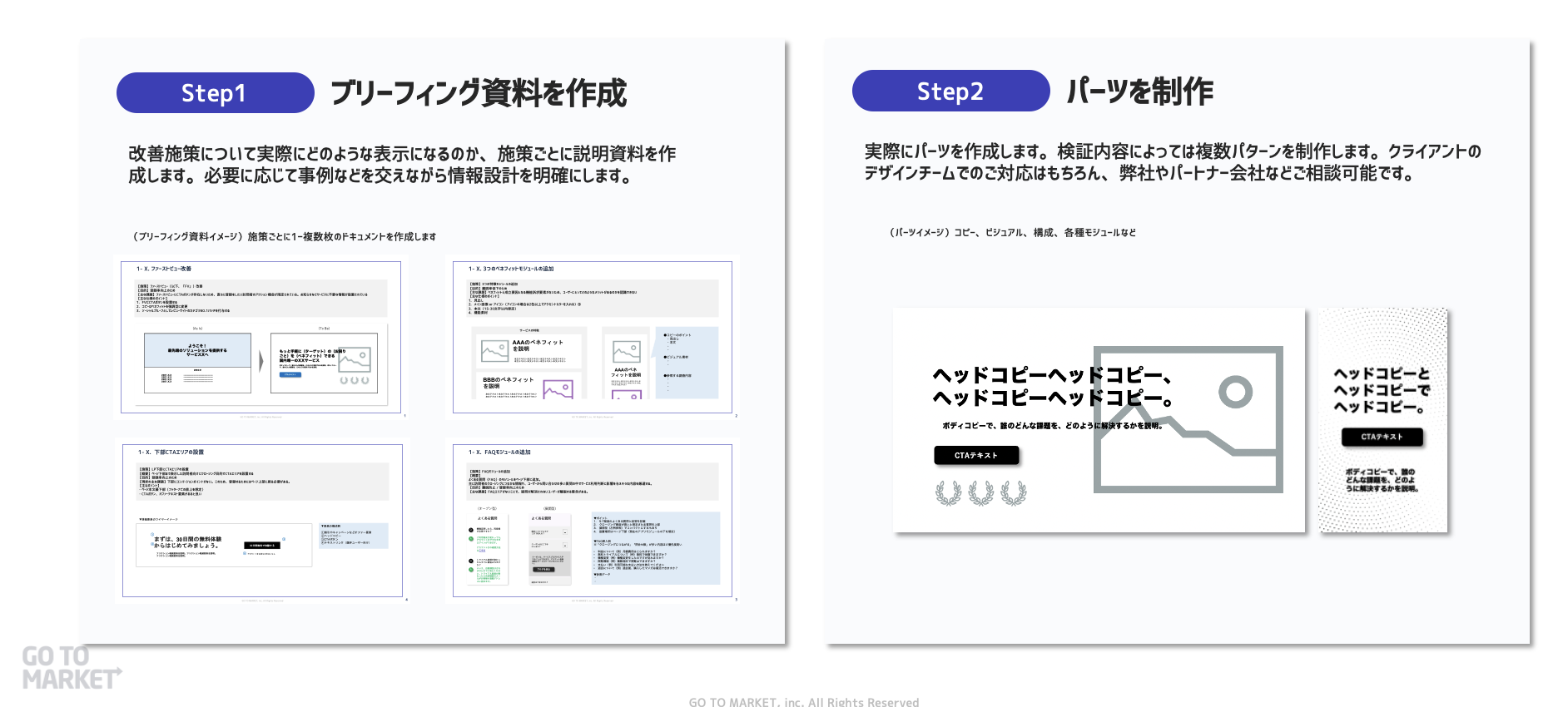

(Step3)プロトタイプ制作

テストパターンのプロトタイプを制作します。制作者にしっかりとブリーフィングを行うことで、仮説検証の意図から制作物が外れないように気をつけましょう。

(参照:GrowthFuel資料)

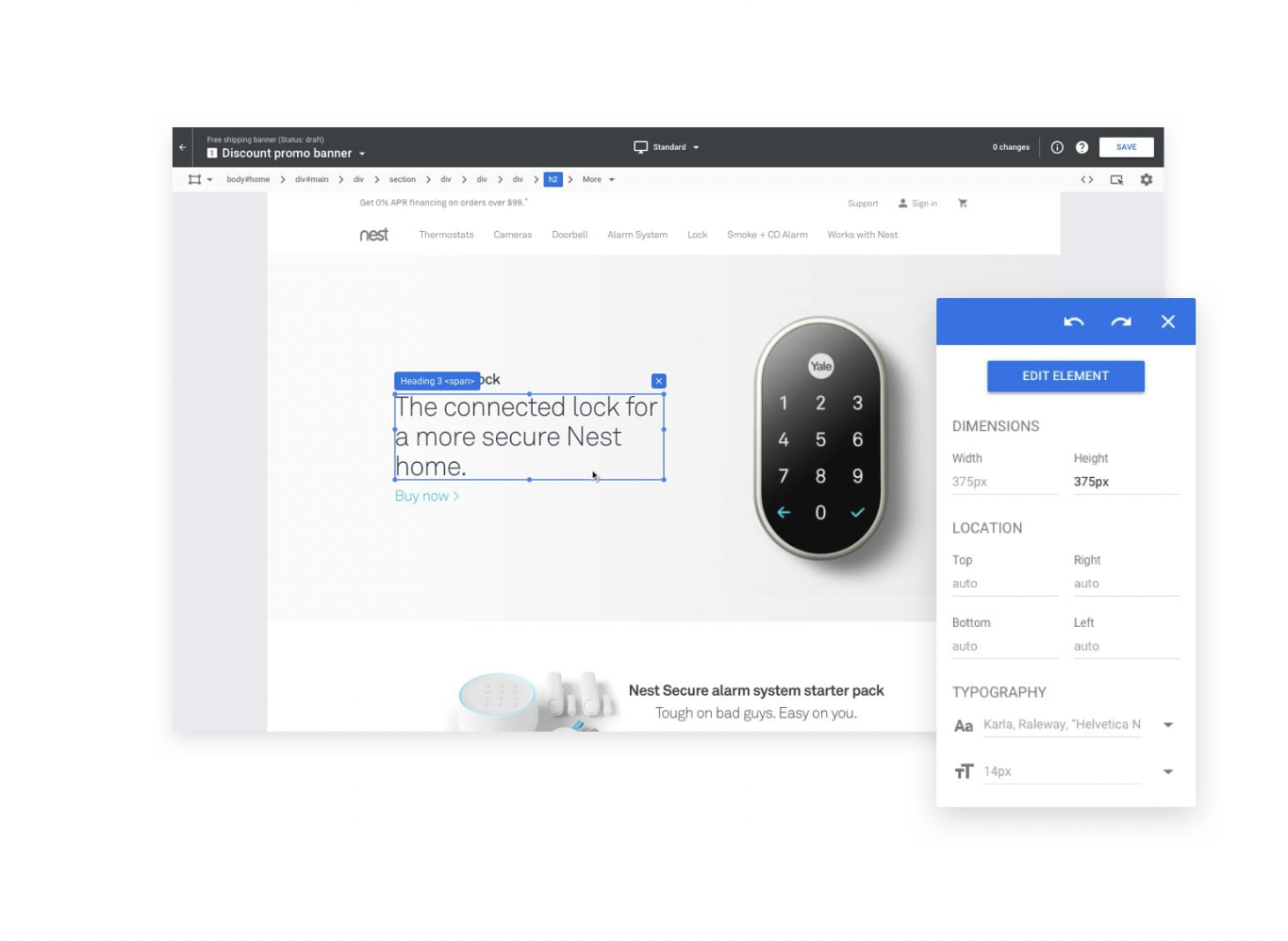

(Step4)実装

プロトタイプ制作ができたら、A/Bテストツールに実装しましょう。プラン通りのパターンや配信対象に設定できているか必ず確認を行いましょう。

(Step5)QA(Quality Assurance)

テストツールの実装が完了したら必ずQAを行いましょう。バグや不具合によってテスト結果は大幅に変わってしまいます。

- デバイスごとに実装されているか

- テストパターンは意図通りか

- ブラウザサイズに問題はないか

(Step6)モニタリング

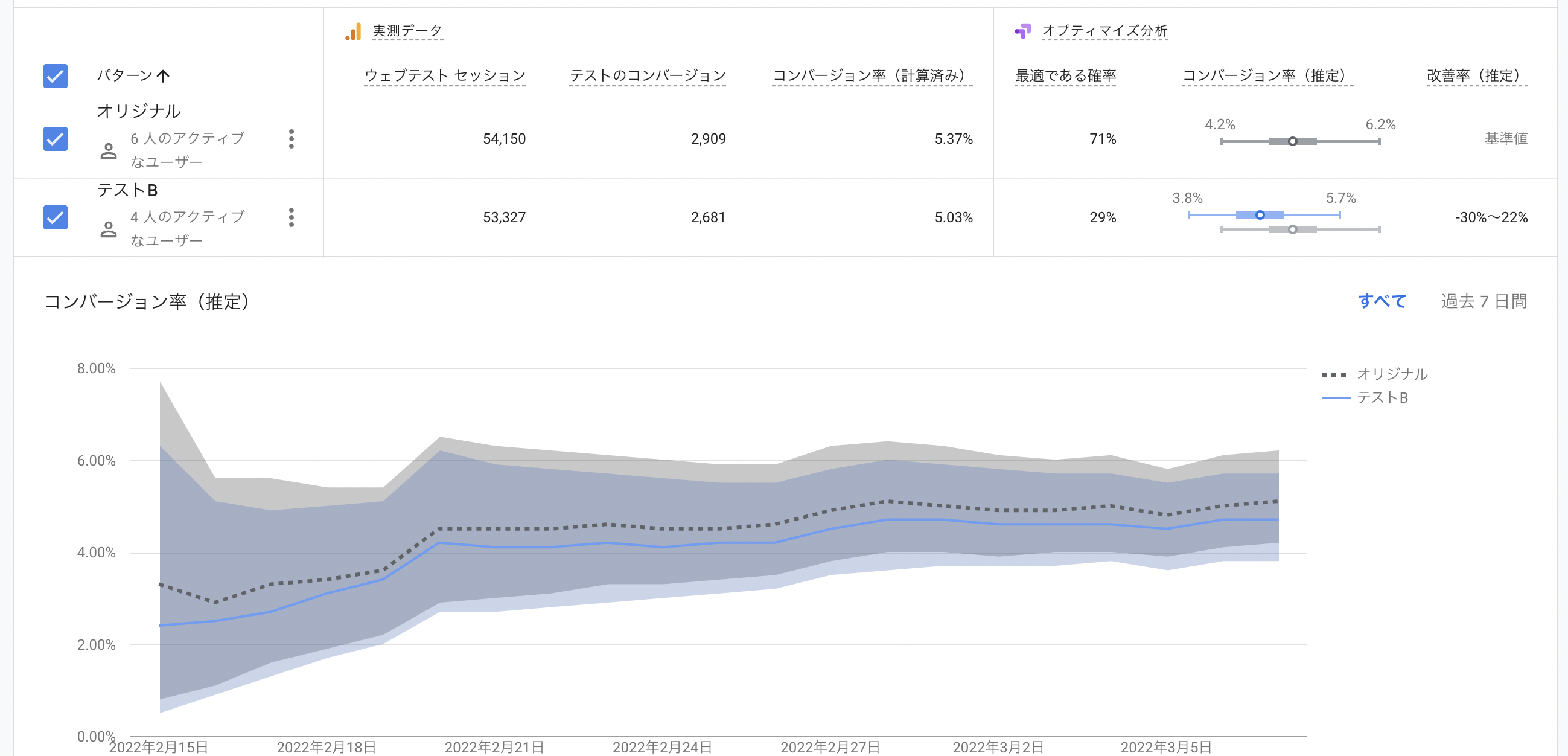

テストが配信されたらモニタリングを行います。一般的なテストツールではほぼリアルタイムに結果が更新されていきます。想定と大きく異なる動きはないか、予想通りのトラフィックで配信されているかをチェックしましょう。

(参考:Googleオプティマイズのダッシュボード)

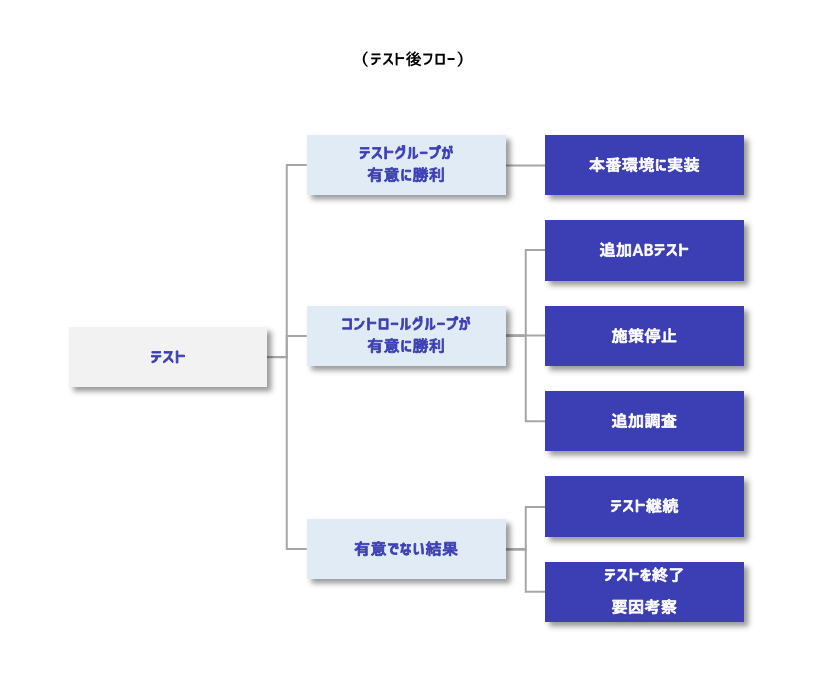

(Step7)レポーティング

テストの終了時には必ずレポーティングを行いましょう。テストによって仮説は証明されたのか、追加のリサーチが必要なのか、計測上の課題はなかったか、1つ1つのテスト結果が全て次の検証につながっていきます。テスト結果は必ずラーニングとともにアーカイブしましょう。

A/Bテストツールについて

最後にA/Bテストツールについて簡単に説明を行います。ツールの仕組みやおすすめのサービスを紹介します。

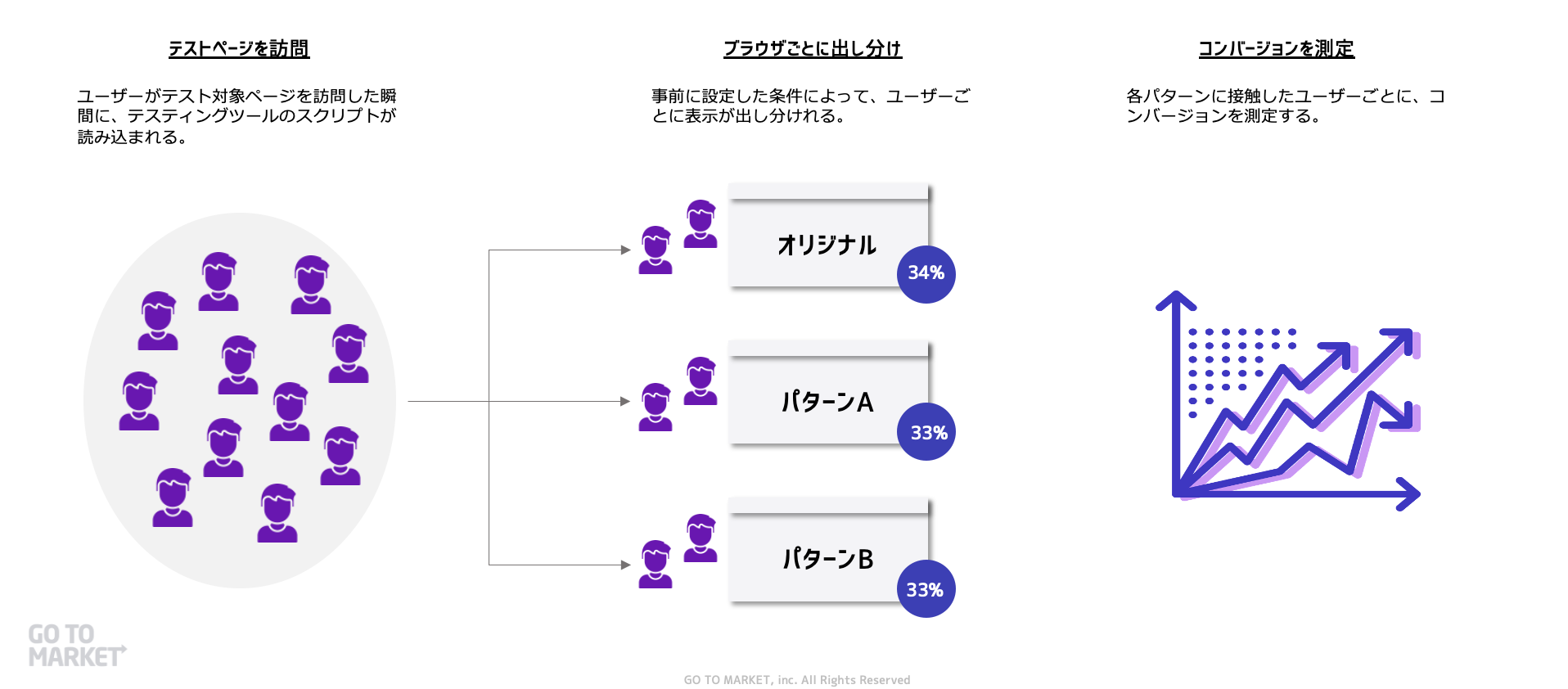

A/Bテストツールの仕組み

A/Bテストツールの仕組みについて簡単に触れておきましょう。多くのA/Bテストツールはサイトにタグを設置します。対象ページに訪問があった際に、ページが読み込まれる瞬間にA/Bテストツールのスクリプトが読み込まれます。事前に設定した条件に応じてスクリプトが実行され、訪問者ごとに表示を出し分けることができます。

続いて具体的なABテストツールについて紹介をします。

Googleオプティマイズ

最もおすすめなのがGoogleオプティマイズです。GoogleオプティマイズはGoogleが提供するテスティングツールです。無料で利用ができます(※)。Googleオプティマイズはローコードで運用ができます。また、リダイレクトテスト、多変量テストなど豊富なテストオプションがあります。Google Analyticsと連携できるため、GA利用の際は設定も簡易かつデータの取扱いもやりやすくなります。初級〜上級者まで幅広く使いやすい点がGoogleオプティマイズの魅力といえます。

メリットが大きいGoogleオプティマイズですが、留意点もあります。GoogleオプティマイズはHTMLの知識が一定必要になるため全くノーコードでA/Bテストができるということはありません。チーム内でHTML知識がないメンバーが運用する場合は活用が限定的になってしまう恐れがあります。無料の場合は有料版と比べて同時テスト数の制限などがあります。

※ アクセス数の多い大規模サイトの場合はGoogleオプティマイズ360という有料版でないと使えない場合があります。

Optimizely

Optimizely(オプティマイズリー)は世界トップシェアを誇るA/Bテストプラットフォームです。OptimizelyはWebでのA/Bテストはもちろん、iOS、Androidなどモバイルアプリでもテストが可能になります。また、あらゆる開発言語でカスタマイズできるためフルスタック&フルカスタマイズでA/Bテスト実施が可能です。

Optimizelyの留意点もいくつかあります。高性能ツールであるため費用感は少し割高になることに加え、海外ツールであるため日本でのサポートが相対的に強くない懸念があります(日本では株式会社ギャプライズが正規代理店として提供しています)。

Ptengine

Ptengineは世界180カ国にサービス提供をするサイト運営プラットフォームです。Ptengineは、ヒートマップ、エクスペリエンス、サイト制作という3つの主要サービスに分かれており、2つ目のPtengineエクスペリエンスでA/Bテストが可能です。Ptengineの魅力は、ヒートマップツール等の解析機能でテスト分析が容易な点が挙げられます。また、テストもほぼノーコードで設定できるためHTMLの知識がなくともドラッグ&ドロップで実行可能です。ポップアップ実装も容易でテストテンプレートの用意もあるため手軽にテストが可能です。また、国内に拠点があるためサポート体制もストレスが少ないでしょう。

一方でPtengineの留意点としては、PV課金型の有料サービスになるため費用が割高になってしまう点です。また、多変量テストなど高度なテスト設計は現状できません。

VWO

VWOもグローバルトップクラスのテスティングプラットフォームです。A/Bテストに関する豊富な機能はもちろんのこと、加えて、ヒートマップ機能や通知送信やCRM機能も搭載されている総合的なマーケティングプラットフォームです。Optimizelyと同様にカスタマイズ性の高い高度なテスト設計ができます。

DLPO

DLPOはDLPO株式会社が提供するA/Bテストツールです。DLPOでは一般的なスプリットテストはもちろん多変量テストやパーソナライズド配信の施策なども可能です。加えて、国内のDMPやCDPとデータ連携可能な点が独自の魅力として挙げられます。

まとめ – A/Bテストの失敗を防ぐために

本記事ではA/Bテストの基礎知識というテーマで、A/Bテストに関する基本的な考え方やA/Bテストの進め方、そしておすすめのA/Bテストツールについて解説をしてきました。最後にA/Bテストの失敗を防ぐためのポイントチェックリストを記載します。

- 課題解決のための仮説設計はできているか:分析、施策リスト

- テストプランニングをしているか:必要なバリエーション数、サンプル数、コンバージョン数、MDEを事前に試算できているか

- プロトタイプは仮説検証の方向性に従っているか:制作者にブリーフィングできているか

- テスト実装後にQA(Quality Assurance)はできているか:ブラウザ、デバイスなどで不具合が生じていないか

- テスト後にラーニングをまとめているかわりに

本記事の内容がA/Bテスト実施の一助になると幸いです。

CRO支援をご検討なら

CRO/Tipsでは、本記事のようにCROに関する様々なナレッジや情報をお届けします。CRO/Tipsを運営している株式会社GO TO MARKETでは、CRO特化のマーケティング支援のプロフェッショナルパッケージ「GrowthFuel(グロースヒュール)」を提供しています。サイト改善、LP改善などにお困りの場合はお気軽に問い合わせください。